Ik besteedde mijn geld om LLM's te benchmarken op Nederlandse examens – zodat jij dat niet hoeft te doen

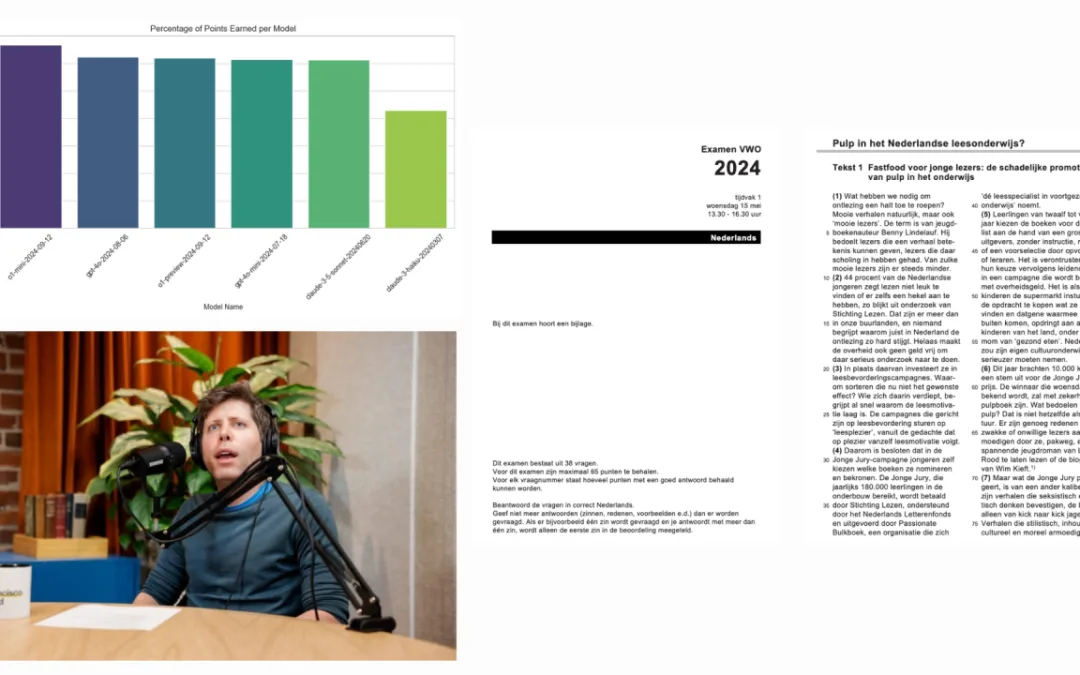

Mijn interpretatie van deze afbeelding: Sam Altman (OpenAI) zit in een podcast en maakt gewaagde claims over nieuwe modellen die veel beter zijn en dat we dicht bij AGI zijn. Tijd om te controleren of dat klopt!

Waarom Nederlandsspecifieke Benchmarks Belangrijk Zijn

Veel van mijn klanten werken met Nederlandstalige producten en hebben AI-modellen nodig die zowel kostenefficiënt als sterk presterend zijn in het begrijpen en verwerken van Nederlands. Hoewel grote taalmodellen (LLM’s) indrukwekkende vooruitgang hebben geboekt, richten de meeste benchmarks zich op Engels of meertalige capaciteiten en verwaarlozen ze vaak de nuances van kleinere talen zoals Nederlands. Dit gebrek aan aandacht voor Nederlands is significant, omdat taalkundige verschillen tot grote prestatieverschillen kunnen leiden wanneer een model niet-Engelse teksten moet begrijpen.

Vijf jaar geleden waren NLP-modellen voor het Nederlands — zoals de eerste versies van BERT — nog verre van volwassen. Destijds presteerden traditionele methoden zoals TF-IDF gecombineerd met logistische regressie vaak beter dan de vroege deep-learning modellen voor Nederlandse taaltoepassingen waar ik aan werkte. Inmiddels hebben modellen en datasets een enorme sprong voorwaarts gemaakt, vooral door de opkomst van transformers en meertalig voorgetrainde LLM’s. Toch is het essentieel om te verifiëren hoe goed deze vooruitgangen zich vertalen naar specifieke talen zoals het Nederlands. De aanname dat prestatieverbeteringen in het Engels ook gelden voor andere talen, gaat niet altijd op, zeker niet bij complexe taken zoals begrijpend lezen.

Daarom heb ik me gericht op het opzetten van een aangepaste benchmark voor het Nederlands, met gebruik van echte examendata van de Nederlandse “Nederlands” examens. Deze examens gaan niet alleen over eenvoudige taalverwerking; ze testen “begrijpend lezen” en vereisen dat studenten de intentie achter diverse teksten begrijpen en genuanceerde vragen hierover beantwoorden. Dit soort taken is bijzonder belangrijk omdat het realistische toepassingen weerspiegelt, zoals het verwerken en samenvatten van juridische documenten, nieuwsartikelen of klantvragen in het Nederlands.

Door LLM’s te benchmarken op deze specifieke taak wilde ik dieper inzicht krijgen in hoe modellen omgaan met de complexiteit van de Nederlandse taal, vooral wanneer ze intenties moeten interpreteren, conclusies moeten trekken en nauwkeurige antwoorden moeten geven. Dit is van groot belang voor bedrijven die producten bouwen op maat van Nederlandstalige gebruikers. Mijn doel was om een meer gerichte en relevante benchmark te creëren om te helpen bepalen welke modellen de beste prestaties leveren voor het Nederlands, in plaats van te vertrouwen op algemene meertalige benchmarks die de nuances van de taal niet volledig weergeven.

Hoe de Benchmark Werkt

Hier volgt een overzicht van het opzetten en uitvoeren van deze benchmark:

PDF-Verzameling: Om te beginnen heb ik meer dan 12.000 PDF-bestanden van Nederlandse staatsexamens verzameld. Deze examens bevatten leesfragmenten en vragen om het vermogen van studenten te toetsen in het begrijpen en interpreteren van Nederlandse teksten.

Data-Extractie: Vervolgens heb ik relevante informatie uit de PDF’s gehaald met behulp van LLM’s, waarbij de tekst werd omgezet in gestructureerde vraag-antwoordparen. Een typische vraag uit een PDF kan bijvoorbeeld zijn: “Wat is de hoofdgedachte van de schrijver in alinea 3 van tekst 2?” Na de extractie ziet dit eruit als: Vraag: Wat is de hoofdgedachte van de schrijver in alinea 3? Correct Antwoord: De auteur stelt dat technologische vooruitgang zowel positieve als negatieve gevolgen heeft (2 punten).

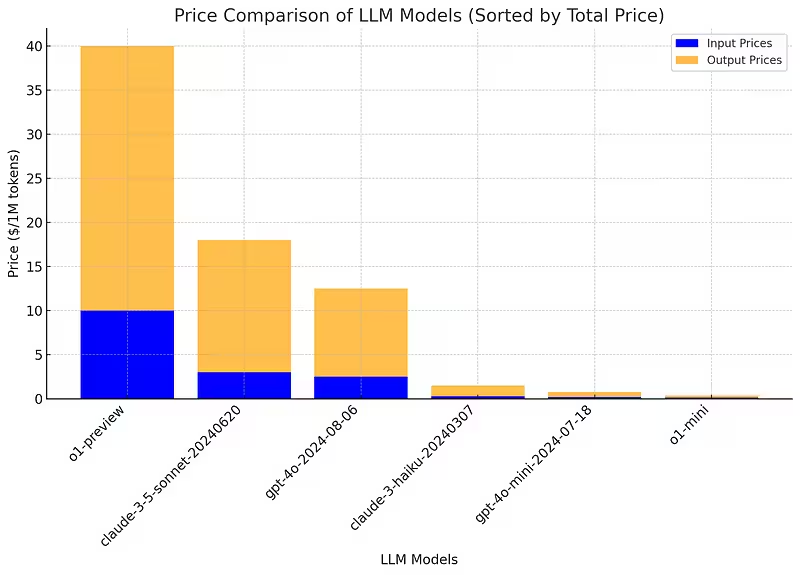

Modelselectie: De geselecteerde modellen omvatten een mix van bekende LLM’s, van kleinere en kostenefficiënte modellen zoals o1-mini en gpt-4o-mini tot duurdere opties zoals o1-preview. Deze modellen zijn getest op Nederlandse leestaken, zoals “begrijpend lezen” uit het Nederlandse “Nederlands” examen. Modellen van Anthropic, zoals Claude-3–5-sonnet en Claude-3-haiku, zijn ook opgenomen om de prestaties te vergelijken met de GPT-familie. Deze eerste benchmark is nog niet volledig, maar ik kan in de toekomst meer modellen toevoegen indien gewenst.

Vraagbeantwoording: Hier werd het interessant! Via de API’s van de LLM’s gaf ik elk model een vraag en de bijbehorende tekst, en liet ik hen de vragen beantwoorden. Het werd minder leuk toen de duurdere modellen in actie kwamen en mijn creditcard zich duidelijk liet horen. De moeite die ik doe voor mijn lezers!

Geautomatiseerde Beoordeling: Met een prompt die het juiste antwoord kent, vraag ik om een objectieve vergelijking: bevat het antwoord van het LLM het vereiste antwoord? Op deze manier worden de antwoorden van de modellen vergeleken met de correcte antwoorden uit de officiële antwoordbladen. Elke vraag krijgt een score op basis van de mate waarin het antwoord van het model overeenkomt met het juiste antwoord.

Scoring en Rapportage: Na het beoordelen worden de modellen geëvalueerd op het aantal punten dat ze hebben behaald ten opzichte van het maximale aantal punten per examen. Deze score laat zien welke modellen sterk presteren en welke moeite hebben met Nederlandse leesbegripstaken.

Het is bijna surrealistisch — LLM’s die andere LLM’s beoordelen en door LLM’s worden nagekeken, zonder een mens in zicht (behalve ik, die de code schreef op een regenachtige middag). Deze methode maakt schaalbare en geautomatiseerde vergelijkingen mogelijk, maar is niet zonder beperkingen. Hoewel dit een goed uitgangspunt biedt voor modelvergelijking, vormt het niet het definitieve oordeel. Toch heb ik dit opgezet om inzicht te krijgen in hoe deze modellen presteren in de context van de Nederlandse taal.

De API-Kosten Dilemma

Het uitvoeren van deze benchmarks bracht aanzienlijke kosten met zich mee. Het verwerken van volledige examenvragen met elke API-aanroep verbruikte snel tokens, waardoor ik meer dan €100 aan API-kosten uitgaf voor deze eerste testronde. Dit dwong me om het aantal vragen dat ik met de verschillende modellen kon verwerken te beperken, maar het leverde toch waardevolle inzichten op.

Als er Nederlandse instellingen geïnteresseerd zijn in een samenwerking voor uitgebreidere benchmarks, werk ik graag samen om dit project op te schalen. Door de scope uit te breiden, kunnen we dieper ingaan op een breder scala aan examens, het aantal beantwoorde vragen aanzienlijk vergroten, en een bredere selectie modellen benchmarken. Dit zou nog uitgebreidere inzichten bieden in de modelprestaties, ons begrip verfijnen van hoe verschillende LLM’s omgaan met Nederlandstalige taken op verschillende onderwijsniveaus en moeilijkheden, en bedrijven helpen om te kiezen voor het best presterende model in plaats van het model met de beste marketing.

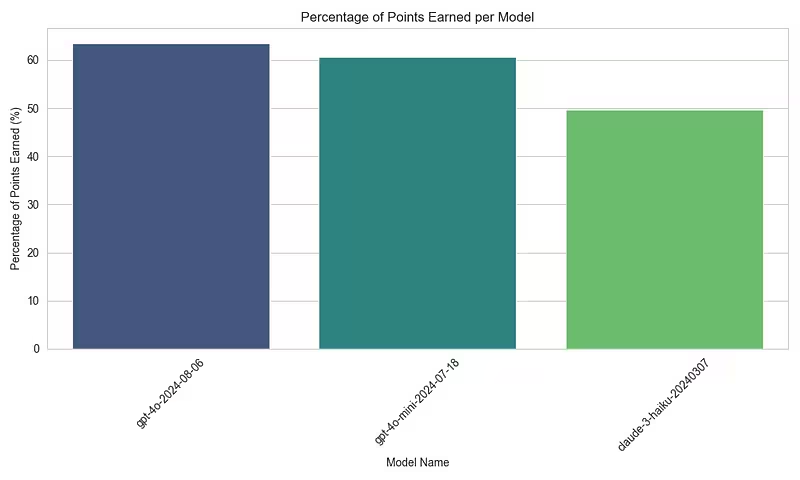

Ik heb twee afzonderlijke benchmarks uitgevoerd: één met kleinere, goedkopere modellen en één met grotere, duurdere modellen, tot ik mijn dagelijkse API-limieten bereikte. Het aantal examenvragen was 329 voor de goedkopere modellen en 104 voor de duurdere “titanen.” Ter vergelijking: dit komt neer op wat een mens zou doen in ongeveer 4 tot 13 volledige examens.

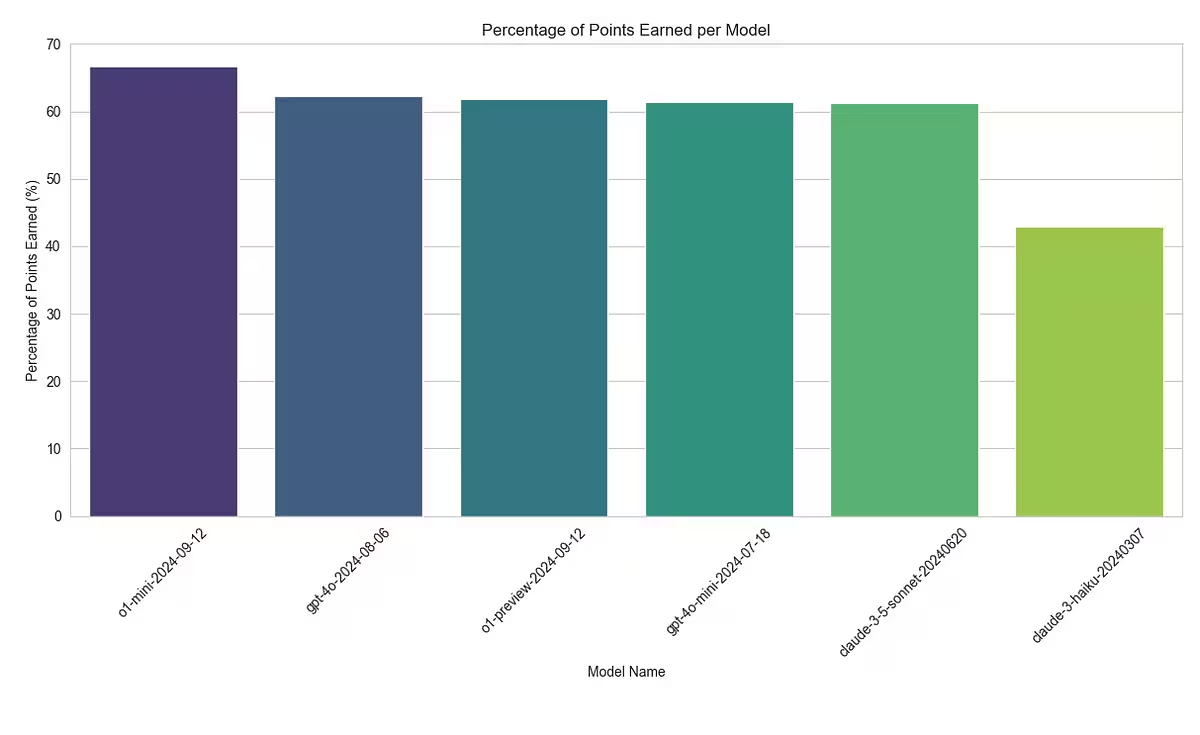

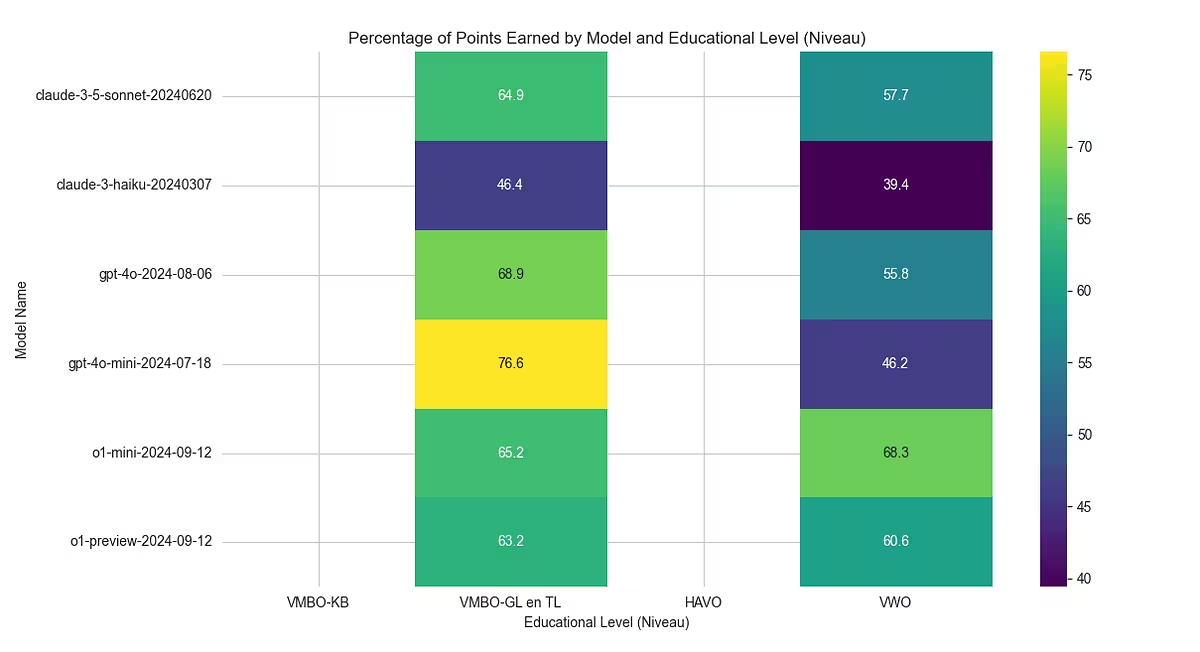

Resultaten van 6 LLM’s die antwoorden op 104 Nederlandse examenvragen vergelijken.

Interessant genoeg presteerde het o1-mini model zelfs beter dan de duurdere opties, zoals GPT-4o en o1-preview. Concreet behaalde o1-mini 66,75% van de mogelijke punten, vergeleken met 62,32% voor GPT-4o en 61,91% voor o1-preview. Op basis van deze resultaten overweeg ik nu om voor Nederlandstalige taken over te stappen van GPT-4o-mini, dat 61,36% behaalde, naar o1-mini vanwege de betere prestaties en aanzienlijk lagere kosten.

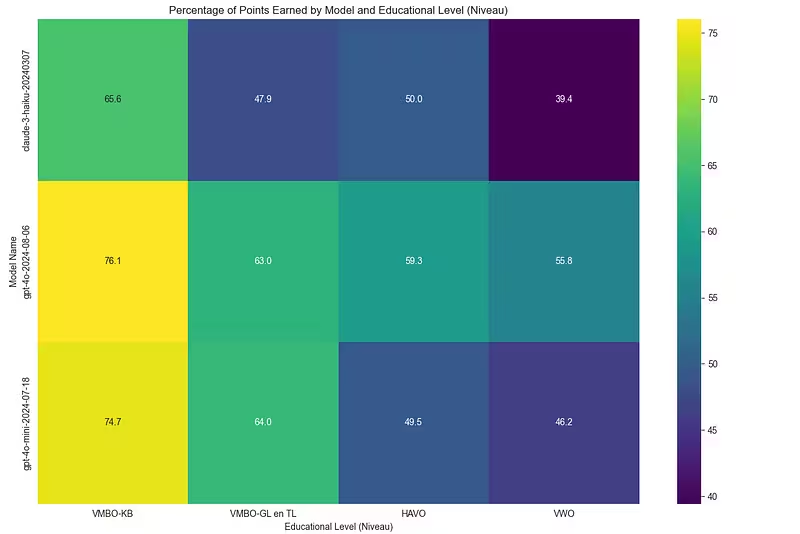

Resultaten van 3 LLM’s die antwoorden op 329 Nederlandse examenvragen vergelijken

Benchmarking van de Modellen: Snel, Goedkoop en… Beter?

Omgaan met Verschillende Onderwijsniveaus:

De examens zijn verdeeld over verschillende onderwijsniveaus, zoals VMBO, HAVO en VWO. Mijn systeem houdt bij hoe goed de modellen presteren op deze verschillende niveaus. Zoals verwacht, behaalden de modellen betere resultaten op de eenvoudigere VMBO-vragen en hadden ze meer moeite met de complexere VWO-vragen. Dit benadrukt de waarde van een kosteneffectief model zoals o1-mini, dat niet alleen goed presteert over uiteenlopende taken heen, maar ook sterke resultaten laat zien bij complexere educatieve inhoud.

Beperkingen en Volgende Stappen

Belangrijk om te vermelden is dat sommige Nederlandse examenvragen mogelijk deel hebben uitgemaakt van de trainingsdata voor bepaalde LLM’s, wat de resultaten kan beïnvloeden. Toch bieden deze benchmarks waardevolle inzichten voor ontwikkelaars die werken aan Nederlandstalige producten.

Dat gezegd hebbende, is het aantal verwerkte vragen tot nu toe relatief beperkt. In toekomstige iteraties ben ik van plan om uitgebreidere benchmarks uit te voeren om diepere inzichten in de prestaties van de modellen te genereren.

Deze aanpak voor benchmarking kan worden uitgebreid naar andere vakken, waarbij ik ook pure tekstvragen heb gefilterd. Het opzetten van een benchmark voor multimodale modellen, die zowel tekst als afbeeldingen kunnen analyseren, zou bijzonder interessant zijn. Veel examens, zoals geschiedenis en aardrijkskunde, bevatten visuele elementen zoals grafieken, kaarten en diagrammen.

In de toekomst kan deze methode eenvoudig worden toegepast op andere Nederlandse vakken, zoals Biologie, Natuurkunde, Scheikunde, Wiskunde A/B/C, Aardrijkskunde, Bedrijfseconomie, Economie, Filosofie, Geschiedenis, Maatschappijwetenschappen, Kunst, Muziek, Tehatex, en talen als Arabisch, Duits, Engels, Frans, Fries, Grieks, Latijn, Russisch, Spaans en Turks. Een uitbreiding naar vakken zoals Natuur- en Scheikunde 1 & 2, Wiskunde, Maatschappijleer en zelfs kunstvakken (bijv. Dans, Drama, Beeldende vakken) zou een breed beeld geven van de modelprestaties over verschillende disciplines heen.

Als je geïnteresseerd bent in het ondersteunen van dit project, neem dan gerust contact op of koop een kop koffie! De code die ik heb ontwikkeld is schaalbaar en kan, met de juiste middelen, een veel groter bereik van Nederlandse examens en onderwerpen aan. Een samenwerking om deze aanvullende vakken en multimodale benchmarks te verkennen, zou nog diepere inzichten opleveren in hoe AI-modellen presteren binnen het Nederlandse onderwijs.

Tot Slot

Voor ondersteuning bij het op verantwoorde wijze bouwen of opschalen van AI- of machine learning-producten, of als je benieuwd bent naar welke LLM’s het best presteren in specifieke talen zoals Nederlands, help ik graag via mijn bedrijf, The AI Factory. Neem gerust contact op! Vond je deze benchmark nuttig? Volg me dan op LinkedIn voor updates over toekomstige inzichten in AI en prestaties.

Lees er meer over in mijn boek De AI Revolutie

Dit artikel is onderdeel van een serie rondom mijn boek “De AI-Revolutie: Hoe kunstmatige intelligentie de maatschappij gaat veranderen (en daar nu al mee bezig is)”, het boek is te koop in de betere boekhandel en online te bestellen. In dit boek duik ik dieper in de invloed van AI op onze toekomst en hoe we als samenleving de juiste koers kunnen bepalen in deze nieuwe, spannende tijd.